Die Digitalisierung

Digitalisierung beschreibt einen Prozess, bei dem man analoge Informationen und Prozesse in eine digitale Form überführt. Das bedeutet, dass Dinge wie Papierdokumente, manuelle Arbeitsabläufe oder physische Objekte zunehmend durch digitale Technologien abgebildet und bearbeitet werden. So wird zum Beispiel ein handschriftliches Protokoll zu einer digitalen Datei. Eine Arbeitsanweisung druckt man nicht mehr aus, sondern bearbeitet diese in digitaler Form durch Softwareprogramme. Dies ist effizienter und flexibler. Dadurch beschleunigt die Digitalisierung die Speicherung, Verarbeitung und Übertragung von Informationen und führt zu einer verbesserten Interaktion zwischen Menschen und Geräten. Die Digitalisierung verändert nicht nur die Art und Weise, wie wir Informationen speichern und kommunizieren, sondern bietet auch neue Möglichkeiten, wie wir Dinge entwickeln und steuern können.

Digitaler Zwilling

Ein Beispiel für die Anwendung der Digitalisierung ist die Erstellung eines digitalen Zwillings. Dieser digitale Zwilling ist ein virtuelles Modell eines realen Objekts oder Systems, das durch die Digitalisierung von Daten entsteht. In der Materialforschung kann dies beispielsweise bedeuten, dass Forschende ein neues Material entwickeln und die Eigenschaften dieses Materials mithilfe von digitalen Modellen und Simulationen besser verstehen. Man erfasst Daten aus realen Experimenten, Messungen und Tests dabei digital und führt diese in einem virtuellen Abbild des Materials zusammen. Digitale Zwillinge begleiten den gesamten Lebenszyklus eines Objekts. Sie nutzen Echtzeitdaten und setzen Simulationen, maschinelles Lernen und intelligente Analysen ein, um Entscheidungen zu erleichtern. Dadurch können sie mehr Probleme aus verschiedenen Perspektiven untersuchen als herkömmliche Simulationen. Sie bieten somit ein größeres Potenzial, Produkte und Prozesse zu verbessern1. Weitere Informationen finden Sie in unserem Artikel Digitalisierung – Von KI zu Industrie 4.0.

Ein elektronisches Laborbuch (engl. Electronic Laboratory Notebooks, ELN) ist ein reales Beispiel für einen digitalen Zwilling. Ein ELB ist ein System, das Forscherinnen und Forschern bei der Dokumentation ihrer Forschungsarbeit hilft, z. B. bei der Beschreibung experimenteller Verfahren, der Durchführung von Probenvorbereitungen und Kalibrierungen und auch der Erfassung von Ergebnissen. Elektronische Laborbücher sollen papierbasierte oder handschriftliche Laborbücher ersetzen, denn diese haben mehrere Nachteile. Beispielsweise hat jede Person einen anderen Stil und Standards bei der Dokumentation von Daten, was zu einer unterschiedlichen Datenqualität führt. Außerdem kann auf Papiernotizen nicht aus der Ferne zugegriffen werden und sie sind nicht automatisch durchsuchbar. ELB versuchen, diese Nachteile auszugleichen und eine verlustfreie Datenübertragung zu gewährleisten.

Beispiele für ELNs:

- Chemotion, Karlsruhe Institute of Technology (KIT)

- eLabFTW, Deltablot

- Herbie, Helmholtz-Zentrum Hereon

- Kadi4Mat, Karlsruher Institut für Technologie (KIT)

- SampleDB, Forschungszentrum Jülich, PGI/JCNS-TA Scientific IT-Systems

- Sciformation, Sciformation Consulting GmbH; Originally started with the Max Planck Institute for Coal Research

Die Digitalisierung selbst bildet die Grundlage für solche innovativen Ansätze. Sie ermöglicht es, große Mengen an Daten zu sammeln und zu analysieren, was neue Werkzeuge hervorbringt. Sie helfen dabei, reale Objekte oder Prozesse besser zu verstehen und zu optimieren, sei es in der Materialforschung oder in anderen Bereichen. In der Produktion können digitale Zwillinge den Herstellern helfen zu entscheiden, was mit Produkten am Ende ihres Produktlebenszyklus passieren soll und ob sie durch Recycling oder andere Maßnahmen verarbeitet werden können 1. Mit dem Einsatz digitaler Zwillinge können sie bestimmen, welche Produktmaterialien wiederverwendbar sind.

Forschungsdatenmanagement

Mit der zunehmenden Digitalisierung der Forschung ist ein effektives Forschungsdatenmanagement immer wichtiger geworden. Forschungsdatenmanagement (FDM) ist der Umgang mit Daten in Forschungsprojekten. Diese Daten werden erhoben, organisiert, gespeichert und dokumentiert. Daten sollen sicher und zugänglich sein. Sie müssen korrekt und vollständig, leicht zu finden und zu verstehen sein.

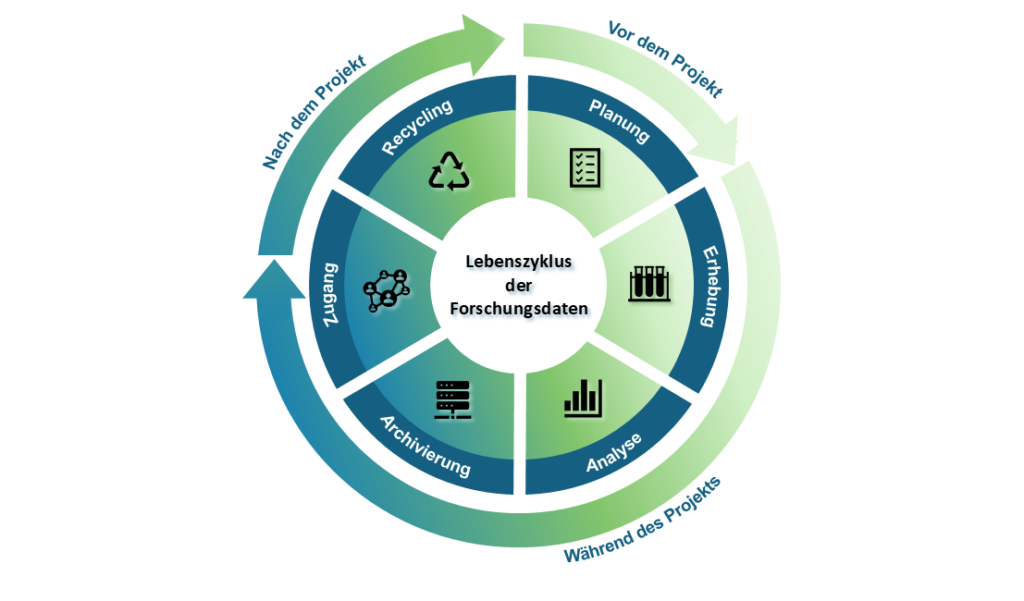

Der Datenlebenszyklus beschreibt die verschiedenen Phasen, die Daten während ihres Bestehens durchlaufen – von der Entstehung bis zur Archivierung oder Löschung. Diese Phasen sind besonders relevant im Kontext des Forschungsdatenmanagements. Sie erfordern strukturierte Planung und Handhabung, um wissenschaftliche Daten langfristig nutzbar zu machen.

Daten haben häufig eine längere Lebensdauer als die Forschungsprojekte, die sie generieren. Forschungsdatenmanagement beginnt bereits in der Planungsphase des Projekts und begleitet es während seines gesamten Lebenszyklus. Die folgende Abbildung stellt diesen Prozess visuell dar.

Forschungskonzeptionsphase: Was passiert vor dem Start des Projekts?

Das Forschungsdatenmanagement beginnt mit dem Planungskonzept, lange bevor Forschungsdaten generiert werden. In dieser Phase entscheiden Forschende, welche Daten oder Datensätze gesammelt werden sollen und welche Richtlinien sie beim Umgang mit ihren Daten befolgen sollten. Viele wissenschaftliche Institutionen, Akteure oder Forschungsgemeinschaften haben ihre eigenen Richtlinien und stellen sie der wissenschaftlichen Gemeinschaft oder den Studierenden bereit. Sie enthalten in der Regel ausführliche Anweisungen zur guten wissenschaftlichen Praxis, zum Umgang mit Forschungsdaten und zur Definition von Forschungsdatenrechten. Für weitere Informationen lesen Sie unseren Richtlinien für gutes Forschungsdatenmanagement Artikel.

Die FAIR-Prinzipien (englisch: findable, accessible, interoperable und reusable) gehören zu den wichtigsten Leitfäden für den Umgang mit Forschungsdaten in der wissenschaftlichen Gemeinschaft. FAIR bedeutet, dass Daten nach Möglichkeit auffindbar, zugänglich, interoperabel und wiederverwendbar gemacht werden sollten. Im Gegensatz zu „open data“ sind sie aber nicht zwingend in vollem Umfang und für jeden frei verfügbar, sondern dürfen zum Schutz von Betriebsgeheimnissen, Patenten etc. unter Verschluss gehalten werden. Weitere Informationen finden Sie in unserem Artikel „Standardisierte Daten und FAIR-Prinzipien“.

Ein Datenmanagementplan unterstützt den nachhaltigen Umgang mit Forschungsdaten vor, während und nach der Projektlaufzeit. Es handelt sich um ein formelles Dokument, das den Lebenszyklus der Daten festhält. Wenn sich die Bedingungen oder Anforderungen während des Projekts ändern, kann dieser Plan sich ändern und weiterentwickeln.

Recherchephase: Forschungsdatenverwaltung während des Projekts

In der Umsetzungsphase konzentriert sich das Forschungsdatenmanagement auf die Erhebung und Analyse von Originaldaten. In dieser Phase führen Forschende Experimente, Messungen und Simulationen durch und gewinnen daraus die Originaldaten. Originaldaten sind Forschungsdaten, die im Rahmen der Planung, Durchführung oder Dokumentation wissenschaftlicher Vorhaben entstehen oder in solchen genutzt werden. Die nachfolgende Analyse der Originaldaten bedeutet mehr als nur die Auswertung der Messergebnisse. Sie umfasst auch die sorgfältige Prüfung, Validierung und Beschreibung der gewonnenen Originaldaten und liefert Metadaten. Metadaten beschreiben die Originaldaten und liefern den Kontext, in dem der Datensatz erstellt wurde. Die Wiederverwendbarkeit von Forschungsdaten hängt wesentlich von der Qualität dieser beschreibenden Metadaten ab 3.

Der Analyseprozess umfasst auch die Digitalisierung und Übersetzung der Daten oder die Anonymisierung bestimmter Datensätze. Die Verantwortlichen müssen entscheiden, wie und wo sie die Daten speichern. Z. B., ob der Datensatz auf einem realen oder virtuellen Server abgelegt werden soll oder ob bestimmte Software für die Datensicherung genutzt werden soll.

Sobald Wissenschaftlerinnen und Wissenschaftler genügend Daten gesammelt und sorgfältig analysiert haben, fassen sie diese in Datensätzen zusammengefasst. Jetzt können sie die Datensätze je nach Verwendungszweck für die gezielte Weitergabe oder Veröffentlichung vorbereiten. An diesem Punkt sollten Forschende oder die jeweiligen Verantwortlichen festlegen, wer auf die Datensätze zugreifen kann und unter welchen Bedingungen man auf die Daten zugreifen kann. Jeder Forschungsdatensatz bekommt eine eindeutige, dauerhafte Kennung (englisch: persistent identifier, PID) von der Datenbank oder der Zeitschrift, in der die Daten gespeichert werden 4. Die Kennung dient dazu, den Datensatz auffindbar zu machen. Forschende müssen bei der Veröffentlichung ihrer Daten die Datenrechte berücksichtigen und meist eine Datennutzungslizenz für ihre Daten auswählen. Eine Lizenz liefert Informationen über die genauen Bedingungen, unter denen andere Menschen darauf zugreifen können.

Nach Abschluss des Forschungsprojekts: Wie kann man die Daten weiter nutzen?

Gemäß guter wissenschaftlicher Praxis müssen Forschende ihre Forschungsdaten archivieren und verfügbar bereitstellen. Die Veröffentlichung und Archivierung von Daten sollte bereits während der Forschungsphase begonnen haben, erhalten aber nach Ende der Forschungstätigkeit eine weitere erhebliche Bedeutung.

Die Daten werden in geeignete Formate umgewandelt und auf entsprechenden Plattformen gesichert. Beispielsweise kann eine Person ihre analysierten Daten auf dem Gruppenserver speichern, sodass andere Mitarbeitende auf die Originaldaten zugreifen können. Alternativ kann sie die Daten auf einer gesicherten Datenaustauschplattform speichern, die auch als sicheres Backup dienen kann.

Wissenschaftlerinnen und Wissenschaftler sollten Forschungsdaten während des gesamten Lebenszyklus verwalten, um sie wiederverwenden und in anderen Forschungsbereichen einsetzen zu können. Denkbar wäre, dass ein Forschungsprojekt auf den Daten eines früheren Projekts aufbaut, was in der Forschung heute weitverbreitet ist. Dann könnten die Daten aus dem alten Projekt wiederverwendet werden und den Beteiligten im neuen Projekt helfen, nicht „bei Null“ zu beginnen oder früher gemachte Fehler zu vermeiden.

Weiterführende Informationen:

- IBM „Was ist ein digitaler Zwilling?“ (Stand letzter Zugang: 02.2025)

- RWTH Aachen, IC „Data Lifecycle“

- Riley, J „Understanding Metadata: What is Metadata, and What is it For?: A Primer„. National Information Standards Organization (NISO) 2017, Stand letzter Zugang: 02.2025.

- Go Fair International Support and Coordination Office (Gfisco)“FAIR Principles – FAIR Guiding Principles for scientific data management and stewardship’“ (Stand letzter Zugang: 25.10.2024).